大语言模型如ChatGPT,以其卓越的写作能力引发了问题。学生们纷纷利用这些模型代写作业,导致一些学校不得不采取禁止ChatGPT的措施。此外,这些模型还存在生成带有事实错误的文本的倾向,因此谨慎的读者可能想知道,在信任某些新闻文章或其他来源之前,是否有生成式AI工具用于代写。

针对这一问题,研究人员提出了Ghostbuster这一先进的AI生成文本检测方法。该方法通过评估文档中每个标记在多个较弱的语言模型下生成的概率,然后将这些概率的函数作为最终分类器的输入进行组合。Ghostbuster无需知道生成文档所使用的具体模型,也无需知道在该特定模型下生成文档的概率。这使得Ghostbuster特别适用于检测由未知模型或黑盒模型生成的文本,例如流行的商业模型ChatGPT和Claude,其概率不可用。研究人员着重确保Ghostbuster具有良好的泛化性能,因此他们在不同领域(使用新收集的散文、新闻和故事数据集)、语言模型或提示下进行了评估。

为什么选择这种方法呢?

当前许多AI生成文本检测系统对于分类不同类型的文本(例如不同的写作风格、或不同的文本生成模型或提示)往往表现脆弱。简单使用困惑度(perplexity)的模型通常无法捕捉更复杂的特征,在新的写作领域表现尤为糟糕。与此相反,基于大型语言模型(如RoBERTa)的分类器虽然能轻松捕捉复杂特征,但容易对训练数据过拟合且泛化性能差。Ghostbuster的方法在这两者之间取得了平衡,既能够捕捉复杂特征,又不容易过拟合。

如何运作

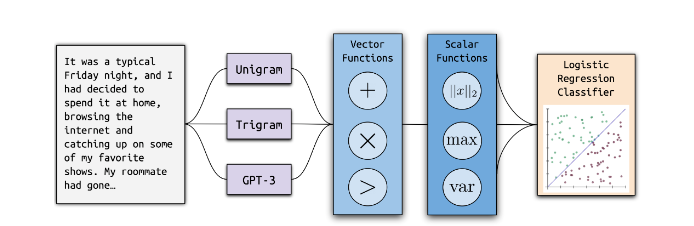

Ghostbuster 采用三阶段训练过程:计算概率、选择特征和分类器训练。

计算概率:通过计算在一系列较弱的语言模型(一个一元模型、一个三元模型和两个非指令调整的 GPT-3模型)下生成文档中每个单词的概率,将每个文档转换为一系列向量、艾达和达芬奇)。

选择特征:使用结构化搜索过程来选择特征,其工作原理是(1)定义一组组合概率的向量和标量运算,以及(2)使用前向特征选择搜索这些操作的有用组合,重复添加最好的剩余特征。

分类器训练:根据最佳的基于概率的特征和一些额外的手动选择的特征训练了线性分类器。

Ghostbuster准确率表现

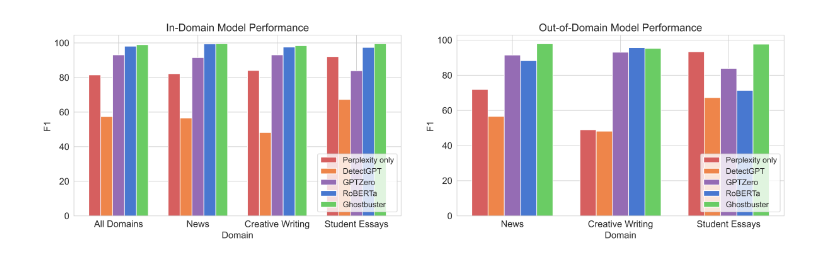

在同一领域训练和测试时,Ghostbuster在所有三个数据集上取得了99.0的F1分数,超过GPTZero5.9F1和DetectGPT41.6F1。在领域之外,Ghostbuster在所有条件下平均取得了97.0的F1,超过DetectGPT39.6F1和GPTZero7.5F1。与此相对,我们的RoBERTa基线在所有数据集的领域内评估时取得了98.1的F1,但其泛化性能不一致。Ghostbuster在所有领域上的性能均优于RoBERTa,仅在领域之外的创意写作中稍逊一筹,但总体上比RoBERTa在领域之外的性能更好(13.8F1差距)。

为了确保Ghostbuster对用户可能提示模型的各种方式的鲁棒性,例如请求不同的写作风格或阅读水平,研究人员评估了Ghostbuster对多个提示变体的鲁棒性。Ghostbuster在这些提示变体上的性能优于所有其他测试方法,达到99.5的F1。为了测试对模型的跨域泛化,研究人员在Claude生成的文本上评估了Ghostbuster的性能,结果Ghostbuster也在92.2的F1上超过了所有其他测试方法。

AI生成文本检测器曾被轻微编辑生成的文本所欺骗。研究人员检查了Ghostbuster对编辑的鲁棒性,例如交换句子或段落,重新排列字符,或用同义词替换单词。大多数在句子或段落级别的更改并没有显著影响性能,尽管如果文本通过重复改写,使用商业检测规避器(如Undetectable AI)或进行大量单词或字符级别的更改,则性能会平稳下降。性能在较长的文档上也表现最佳。

由于AI生成文本检测器可能会将非母语英语的文本误判为AI生成的文本,研究人员评估了Ghostbuster对非母语英语写作的性能。所有测试模型在三个测试数据集中的两个上都具有95%以上的准确率,但在第三组较短的散文中表现较差。然而,文档长度可能是主要因素,因为Ghostbuster在这些文档上的表现几乎与其在其他长度相似的领域之外文档上的表现一样好(74.7F1),后者的F1在75.6到93.1之间。

希望将Ghostbuster应用于潜在的文本生成的禁区使用的用户应该注意,对于较短的文本、远离Ghostbuster训练领域的领域(例如不同的英语变体)、非英语母语的文本、人工编辑的模型生成或通过提示AI模型修改人工创作的文本,错误更有可能发生。为了避免延续算法伤害,我们强烈不建议在没有人类监督的情况下自动惩罚所谓的文本生成使用。相反,我们建议在分类某人的写作为AI生成可能会对其造成伤害时,谨慎使用Ghostbuster的人机协同使用。Ghostbuster还可以在一系列较低风险的应用中发挥作用,包括从语言模型训练数据中过滤AI生成的文本,并检查在线信息源是否为AI生成。

Ghostbuster是一种先进的AI生成文本检测模型,在测试的领域中取得了99.0的F1性能,相较现有模型取得了实质性的进展。它在不同领域、提示和模型上表现良好,对于识别来自黑盒或未知模型的文本非常合适,因为它无需访问生成文档的具体模型的概率。

Ghostbuster未来的方向包括为模型决策提供解释和提高对试图欺骗检测器的攻击的鲁棒性。AI生成文本检测方法还可以与水印等替代方法一起使用。研究人员还希望Ghostbuster能在过滤语言模型训练数据或标记网络上的AI生成内容等各种应用中发挥作用。

工具地址:https://ghostbuster.app/

论文网址:https://arxiv.org/abs/2305.15047

github项目网址:https://github.com/vivek3141/ghostbuster

大家尝试在这里猜测文本是否是人工智能生成的:ghostbuster.app/experiment

您可能关注: AI工具

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表炎黄立场。